Vous avez investi beaucoup de temps et d’argent sur le référencement de votre site web ? L’acquisition de trafic n’est toujours pas au rendez-vous ?

Après avoir réalisé un audit de contenu sur les mots-clés de votre site, la structure des pages et la qualité du contenu produit, l’audit technique est l’élément principal pour analyser les performances de votre site web.

Depuis la nouvelle mise à jour des algorithmes Google en 2021, 4 nouveaux indicateurs de performance font leur apparition chez le géant américain. Ils ont pour but de rendre le web plus rapide pour les utilisateurs, en mesurant régulièrement le temps de chargement et d’interactivité de votre site web.

Alors, comment éviter une sanction de performance de Google ?

Nous allons présenter la méthodologie Digilityx pour contrôler 130 éléments techniques de votre site de façon efficace. Ils seront détaillés dans notre check list à télécharger en format Excel, avec tous les outils nécessaires pour devenir le roi de l’audit !

Qu’est ce qu’un audit technique ?

L’audit technique est la pierre angulaire de votre travail sur l’amélioration des performances de votre site. En vérifiant des points précis via cet audit, il est possible de trouver les failles qui pénalisent votre position sur les moteurs de recherche.

Ces failles la pénaliseront plus encore depuis la mise à jour Google Page Experience si vous ne réagissez pas.

Le principal objectif de votre audit technique SEO sera d’identifier les différents points à travailler en priorité. Votre meilleur outil pour démarrer votre audit est encore celui de Google.

Commencez par corriger les plus gros handicaps de votre site. Il sera plus simple et plus encourageant de poursuivre le reste de vos optimisations par la suite.

Une fois mis à jour, vous commencerez peu à peu à observer une amélioration de votre référencement naturel en atteignant une meilleure position sur les SERPs des moteurs de recherche.

Atteindre la première page de résultat, voire les trois premières lignes est un objectif que vous ne devez pas perdre de vue. Si vous ne l’atteignez pas, votre travail et vos efforts en SEO auront été futiles.

Il est bon de rappeler que plus de 90 % des utilisateurs restent sur la première page de résultat. Parmi ces utilisateurs, 30 % d’entre eux s’arrêtent au premier résultat.

Les prérequis avant de vous lancer :

- Avoir accès au compte Google Analytics & Search Console

- Télécharger un crawler : Screaming Frog (gratuit), Oncrawl / Botify (free trial)

- Si vous avez accès à vos logs serveur, accéder à un analyseur de logs spécifique (par exemple Oncrawl)

- L’historique du site avec les dernières modifications effectuées sur le site (par exemple une migration)

1. Crawler vos pages

La première étape de votre audit technique est le crawl complet du domaine et sous-domaine. Cela consiste à utiliser un programme informatique conçu pour imiter le scan de Google sur votre page. Le crawler recherche et analyse toutes vos données pour l’indexation des contenus sur Google.

1.1 Robots d’indexation

Il s’agit de la première colonne du crawl, permettant de comprendre votre positionnement sur les SERPs. L’indexation et le crawling sont les principales méthodes de Google pour explorer régulièrement vos pages et contenus web. Il occupe une place très importante dans l’optimisation du SEO. La compréhension des algorithmes de Google et du crawling nécessite de réaliser le même type de scan en interne.

1.2 Fichier robots.txt

Le robots.txt est un fichier texte, à ne pas confondre avec la meta robot. Il n’est pas présent sur tous les crawlers, mais vous pouvez aller directement à la racine de votre site web. Ce fichier interdit aux robots de Google l’indexation de certaines zones de votre site web (alors que la meta robot est effectuée par page uniquement ). Le fichier robots.txt est le premier élément analysé par les robots de Google, il est donc essentiel d’en avoir connaissance.

Petit point également sur le sitemap, sous format fichier XML, qui liste l'ensemble de vos URL des pages à indexer par Google. Il peut permettre de déclarer des pages invisibles dans votre arborescence de liens. Il doit être inséré directement dans la Search Console.

1.3 Balise meta-description

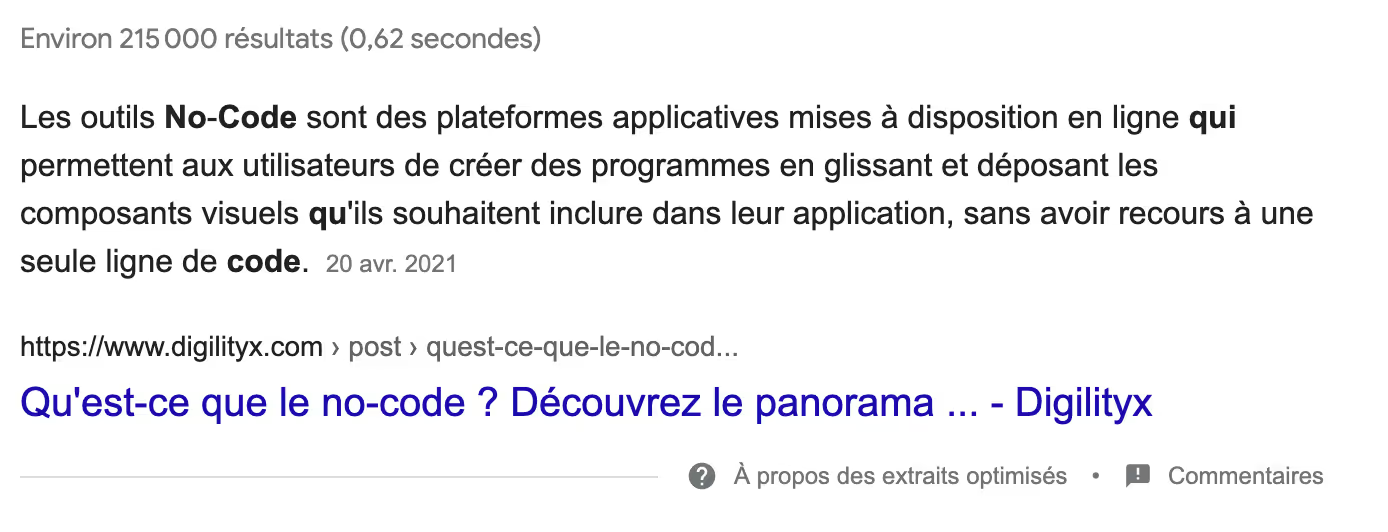

La longueur maximum est de 920 pixels, soit environ 150 caractères. Attention, pour le mobile, c’est légèrement plus bas (130 caractères). Depuis les dernières mises à jour des algorithmes, Google a la possibilité de changer votre meta description par une phrase issue de votre page qu’il jugerait plus pertinente.

Vérifiez qu’il s'agit bien de la meta d’origine pour contrôler la pertinence de vos résultats. Il doit y avoir un message clair et précis pour décrire au mieux le contenu proposé.

Depuis 2021, Google laisse la possibilité de remplir une META description jusqu’à 300 caractères. C’est souvent la solution adéquate lorsque Google ne choisit pas la méta d’origine car il considère que vous n’êtes pas assez précis.

Assurez-vous également que vos mots clés sont bien présents (minimum 1 prioritaire et 1 secondaire).

1.4 Balise meta title

La longueur maximum est de 500 pixels, soit entre 60 et 70 caractères. Vérifiez qu’il n’y a pas de mots de liaison ni de mots en majuscules. Si votre balise title est trop longue, elle sera coupée par « … ».

Il faut analyser le nombre de mots-clés sur chaque titre (au moins 1 mot clé principal) en évitant les contenus dupliqués et les répétitions.

1.5 Balise meta canonique

Cette balise indique à Google l’adresse de référence pour un ensemble d’URL. Si vous possédez plusieurs pages avec un contenu identique (par exemple différentes variations d’un produit sur votre site e-commerce), il ne faut pas que Google les considère comme du contenu dupliqué.

Cette colonne est très souvent mise de côté lors du crawl, car les cases sont vides. Vous pensez ne pas être concerné par du contenu dupliqué, mais c’est pratiquement toujours le cas.

Par exemple sur notre site internet, https://www.digilityx.com/ et https://digilityx.com/ sont deux portes d’entrées différentes, mais avec le même contenu. Il s’agit bien de deux pages différentes par Google, qu’il considère comme contenu dupliqué et qu’il pénalise. Il faut donc ajouter une méta canonique.

Vérifiez donc dans le tableau de crawl que vos meta canoniques sont bien insérées sur vos doublons de page. Certains CMS génèrent de façon automatique vos meta canoniques, mais attention de ne pas en avoir sur toutes vos URLs.

1.6 Balises titres (H1>H2>H3..)

Grâce à ces différentes balises, vous devez définir les différents niveaux de contenus en les classant par ordre d’importance. Il doit toujours y avoir une balise title H1 car il s’agit du titre de la page. C’est la section la plus importante pour Google, mais vous ne devez pas avoir plusieurs balises H1 par page. Il y a les H2 et H3 qui vous servent à organiser les sous-parties (H4>H5>H6 sont très rarement utilisées en SEO)

Auditez également le nombre de mots-clés présents dans chaque balise car l'intérêt SEO est très fort. Évitez les titres en majuscules, le contenu dupliqué et privilégiez les bullets points ou listes à chiffres pour être en position 0 :

1.7 Redirections et erreurs de pages

La colonne “code de statut” indique la réponse du serveur à une requête faite par l’utilisateur. Elle se produit lorsqu’il demande une URL sur votre serveur Web.

Nous vous avons sélectionné les 6 codes HTTP les plus courants :

200 : Page sans erreur - traitée avec succès

404 : Erreur de page - Document non trouvé

301 : Redirection permanente

302 : Redirection temporaire

410 : La ressource demandée a disparu

500 : Problème de serveur

Les pages 404 devront être redirigées vers des pages sans erreur, grâce notamment avec une redirection permanente (301).

Il faut faire attention à limiter le nombre de redirections temporaires (302) car Google considère que le site est en “travaux”.

Pour les erreurs 500, cela est normalement dû à une maintenance de votre site ou une surcharge de ressources. Il faudra refaire un crawl de vérification dès que votre opération de développement sera terminée.

1.8 Indexabilité

Dans le colonne “META-ROBOTS”, certaines pages non souhaitées peuvent-être indexées (ou inversement).

Vous pouvez utiliser la balise meta name=”robots” dans votre CMS pour rendre ces pages non-indexables. Elle est positionnée dans le HTML de chaque URL pour amener les robots Google sur vos pages les plus pertinentes.

Il y a également d’autres balises meta robots qui peuvent être présentes :

- Follow/no follow : permet de dire à Google de suivre tous les liens sur cette page même si la page n’est pas indexée,

- All : page “index” et “follow”,

- None : page “noindex, nofollow”,

- Noimageindex : ne pas indexer les images de la page,

- Unavailable_after : donner une date temporaire de l’indexation de la page,

- Noarchive : ne pas montrer les liens cachés dans les SERPs,

- Nosnippet : ne pas montrer de focus sur des éléments extraits du contenu (en position 0),

- Notranslate : ne pas proposer de traduction automatique de la page.

1.9 Profondeur des pages

Le crawler établit une profondeur de page, entre 1 et 6, qui correspond au nombre de clics nécessaire pour atteindre l’URL spécifique depuis la home page, en utilisant le chemin le plus rapide

Vérifiez que vos URLs ne possèdent pas une profondeur supérieure à 3, synonyme de performance très faible pour Google.

Si certaines URLs sont difficiles d’accès, les robots Google ne les vérifieront pas aussi régulièrement que les pages d’une profondeur de 1-2 et vont faire baisser les chances d’un bon référencement.

2. Analyse de la performance des pages

Aujourd’hui, l’algorithme de Google ne tolère plus les pages trop longues à charger. L’optimisation globale et individuelle des pages indexées sur votre site est dorénavant incontournable.

2.1 Prioriser le contenu en haut de page

Le contenu “en haut de page” correspond à l’ensemble des éléments visibles au-dessus de la ligne de flottaison.

Une page de site internet peut mettre du temps à se charger complètement. En donnant la priorité au contenu de haut de page, ces éléments seront chargés en priorité.

Le reste de la page se chargera pendant que l’internaute lira le contenu déjà disponible.

De cette manière, les internautes auront accès à une première partie du contenu, ce qui aura pour conséquence de diminuer le risque d’un fort taux de rebond.

Le contenu du haut de la page devra se trouver au début du code HTML.

2.2 Optimiser son code et autoriser la compression GZIP

Grâce à un travail sur le code de son site, il est possible d’identifier des optimisations sur son, HTML, son CSS et son JavaScript. Une fois appliquées, elles augmentent l’efficacité avec laquelle le serveur va les lire et les interpréter.

Le code va s’alléger et la page web sera moins lourde et moins longue à charger. La vitesse de chargement du site sera plus importante et le temps de chargement réduit.

Cette optimisation se fait sur des éléments dont on peut se passer sans impacter la compréhension du site.

La compression GZIP, quant à elle, permet de réduire le temps de téléchargement du code HTML, CSS et JavaScript. Quand ils sont compressés, ces fichiers sont plus légers.

Dans la pratique, un humain ne voit pas la différence. Ce type de conversion est très bien supporté par les navigateurs.

Certains outils comme Check GZIP Compression permettent de vérifier si la compression GZIP est activée sur votre site.

En résultat final, vous devriez obtenir un code illisible pour des humains mais beaucoup plus rapide à lire pour des machines.

2.3 Autoriser la mise en cache des ressources

La mise en cache des ressources permet de réduire le nombre d’éléments à charger pour un internaute.

Cela permet au navigateur de stocker un certain nombre d'éléments lors de la première visite sur le site et qui ne seront plus à charger la prochaine fois.

Cela fluidifie la navigation et augmente la vitesse de chargement d’une page. En cas de modification, de mise à jour de la page, seuls les nouveaux éléments seront chargés, le reste étant dans le cache du navigateur.

2.4 Optimiser le contenu média

Une page lourde, donc lente à charger, est souvent la conséquence d’une accumulation de fichiers média trop volumineux. L’optimisation de ces fichiers a un impact considérable sur leur temps de chargement.

Sur ce point, nous avons déjà développé une liste de bonnes pratiques dans notre premier épisode de cette série sur le SEO.

Faire un lien avec un point d’ancrage via webflow

2.5 Investir pour son serveur

L’hébergement web représente (ou doit représenter) l’une des plus grandes dépenses pour un site. Il faut être prêt à débloquer un certain budget pour en avoir un de qualité.

L’idéal est d’avoir un serveur dédié au lieu d’un serveur mutualisé.

Un hébergement mutualisé stocke plusieurs sites internet sur le même serveur. Les performances du serveur sont donc divisées par le nombre de sites internet présents sur celui-ci. Cela impactera négativement les performances et le temps de chargement du site web.

3. Analyse de l’historique du site

L’audit technique ne se limite pas simplement à des outils SEO. ll doit être complété par un examen visuel à 360 degrés sur la performance digitale globale de votre site internet. Nous vous conseillons d’utiliser la checklist Digilityx ci-dessous avec toutes les étapes à suivre.

3.1 Navigation utilisateur

Le premier examen visuel concerne les problèmes liés à l’architecture qui peuvent gâcher un site et la navigation des utilisateurs. Le logo du site doit posséder un lien vers la page d'accueil. Également, les ancres de lien du menu doivent être optimisées.

La navigation doit aussi être codée en HTML, pas en Javascript (c’est souvent le cas).

Y'a t-il des mots-clés pertinents dans les ancres de texte du menu ? (sans répétition).

Vérifiez également que tous les silos (l’ensemble de vos pages mères) de votre site sont accessibles depuis le menu principal.

La présence d’un fil d'Ariane est également recommandée pour améliorer le maillage interne. Il doit être en HTML et toujours visible au-dessus du titre H1.

Il doit posséder des noms assez courts, être optimisé avec des " > " et doit toujours commencer par le nom de la page mère.

3.2 SEO International

Il est essentiel de posséder une extension pour tous vos pays cibles. Le site doit utiliser des sous-dossiers (ou sous-domaines) pour chaque langue si vous souhaitez vous étendre à l'international.

Google est très exigeant sur la possibilité de basculer d'une version à une autre pour ne pas faire perdre de temps à l’utilisateur. Vérifiez également que chaque domaine est hébergé dans le pays cible. La devise doit également être différente pour chaque pays, tout comme les informations de contact.

Checklist pour l’audit technique SEO

Nous proposons gratuitement une checklist complète pour n’oublier aucun élément lors de votre audit SEO. Le lien pour l'obtenir est juste à la fin de cet article.

Tous les changements des algorithmes Google 2021 y sont inclus !

Elle prend en compte les points importants à auditer en fonction du contenu, des contraintes techniques et de l'autorité de votre site. La checklist ultime pour tous les consultants SEO et content manager !